|

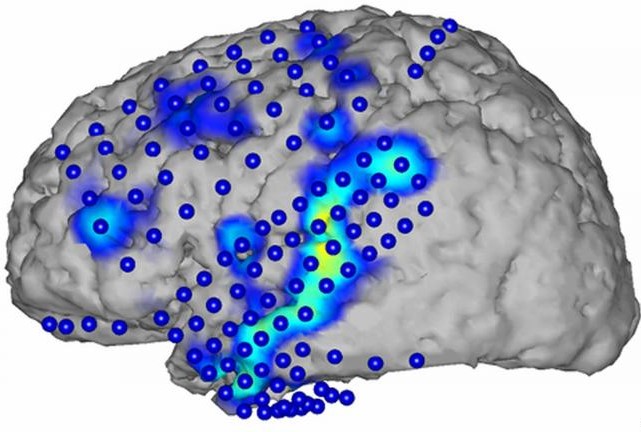

Was ist Sprache? oder: Was Psychologen und Hirnforscher über die Konstruktion von Sprache wissen Was die Evolutionsbiologen zur Bedeutung der Sprache Zur Sprache als ursprünglichem Medium des menschlichen Geistes - MG-Link Das Gehirn verarbeitet in einem komplexen Mechanismus akustische Wahrnehmungen zu Wort-Lauten und diese zu Sprach-Bewusstsein. Die in das Ohr eindringenden Schallwellen (1) werden in elektro-neuronale Impulse „übersetzt” und zum auditorischen Cortex weitergeleitet, dabei nach räumlichen und zeitlichen Merkmalen analysiert. Dort werden Wortformen, grammatikalische Regeln und Satzstruktur analysiert. Während die Tonkurve ohne Lücke ist, ohne Pause, phantasieren wir Wortgrenzen. Der Unterschied zwischen „kam Opi um” oder „kam Opium” ist keiner der Laute, er wird im Gehirn gemacht. Beim Sprechen lassenwirunserewörterineinanderfließen, das Gehirn muss daraus die Sprach-Elemente selektieren. Das passiert in Rückkoppelung mit Analyse von Bedeutung - das Gehirn konstruiert denkbaren Inhalt, auch wenn die Geräusche nur entfernt eine Ähnlichkeit mit speziellen Sprachlauten aufweisen. Aus den Lauten und den dem „Satz” zugrunde liegenden grammatikalischen Strukturen (Buchstabe, Wort, Syntax) lässt sich der Sinn der transportierten Informationen nicht direkt ableiten. Das Phänomen ist aus dem Alltag bekannt: Wer eine ihm völlig unbekannte Sprache hört, assoziiert hin und wieder Worte aus einer ihm bekannten Sprache. Die Sprachwahrnehmung ist so komplex, dass Programmierer bis heute vergeblich versuchen, eine Spracherkennungs-Software zu erfinden, die die flüssige Sprache dutzender von fremden Sprechern „verstehen” kann. Steven Pinker sah in der Sprachfähigkeit ein biologisches Wunder und nannte sie „Sprachinstinkt”. Die Sprachfunktionen sind im Brocca- (2) und Wernicke-Areal (3) des Gehirns konzentriert, aber nicht darauf beschränkt. Die Verarbeitung von Wort-Lauten zu sinnvoller Sprache beschäftigt weit mehr Bereiche des Gehirns. Das Gehirn gleicht den Fluss der akustischen Sinneseindrücke mit seinem erworbenen, abgespeicherten „Lexikon der Wort-Laute“ ab und nur wenn die - mit Erinnerungsstücken verglichen - „Sinn“ geben, werden sie als inhaltliche Bedeutung eines Satzes zu Bewusstsein gebracht. Der Sinn ist dabei eine „emergente” neue Wirklichkeit. Das Gehirn ordnet den erkannten Sprachlauten die komplexen Erinnerungs-Gehalte zu – bestimmte Worte rufen bei dem einen Menschen Emotionen hervor, bei anderen nicht. Schon parallel zum Hören beginnt das Gehirn, eine Antwort auf das Gehörte zu planen – zunächst vorsprachlich. Die Hirnaktivitäten von Sprecher und Hörer laufen also gekoppelt ab. Damit ein flüssiger Dialog entsteht, müssen Zuhörer frühzeitig aus dem Kontext der Sprech-Situation ahnen, was Sprecher sagen wollen. Zur Formulierung der Antwort braucht es dann Grammatik und Wortformen, die metrisch, phonologisch und silbisch gegliedert, in motorische Arbeitsanweisungen überführt und an die Artikulationsorgane weitergegeben werden. Für den motorischen Teil der Sprachproduktion muss unser Gehirn dutzende von Muskeln steuern, nicht nur die Zunge und den Kehlkopf, sondern auch Lippen, Gaumen, Rachen, Kehldeckel und Lunge. Auch Zähne und der Nasenraum sind für die Artikulation wichtig. Menschen erzeugen bis zu 180 Wörter oder 500 Silben pro Minute. Der Prozess erfolgt in Millisekunden – eine Leistung, zu der kein Computer bislang in der Lage ist. Die Sinnzuordnung ist in der Kommunikation entscheidend. Ein Beispiel. Anne fragt Peter vor dem Fahrkartenautomaten: „Hast du mal 'n Zehner?“ Peter antwortet: „Nimm doch die Karte!“ Peter weiß sofort, dass Anne einen Zehn-Euro-Schein meint, und dass sie nicht wissen will, ob er einen hat, sondern ihn implizit bittet, ihm einen zu geben. Würde er „Ja“ antworten, wäre das also kommunikativ unpassend und eher ein Fall für Komiker. Anne weiß, dass „Karte“ eine EC-Karte meint. An der Sprachanalyse sind große Mit Blicken und Gesten – und den Händen reden Lautartikulationen entstanden ursprünglich als Beiwerk und Vervollkommnung des motorischen Verhaltensarsenals des Körpers. Gesten der Hände sind Signale des Körpers und wurden von Lauten begleitet. Die sprachlichen Signal-Möglichkeiten, die daraus entstehen, blieben zunächst eingebunden in körperliche Wahrnehmungs-Erfahrungen, aus denen die Laute ihre Bedeutung erlangt haben. Wie stark die Gesten mit der Sprachfähigkeit verknüpft sind, zeigt die Frage nach der Sprachkompetenz von Gehörlosen (4): Das Gehirn ist also auf Sprache an sich spezialisiert, nicht auf das akustische Sprechen. Der Gehirnforscher Vilayanur Ramachandran nennt Beispiele für eine tief im Gehirn verwurzelte Verbindung von bestimmten visuellen Erscheinungen und auditorischer Repräsentanz. Er zeigte seinen Studenten einen Stern mit wilden Zacken und ein mit runden Schwüngen geformtes Wolken-Bild. Wenn sie die Worte „teeny weeny“ einerseits und enorm, „large“, „grand“ diesen Formen zuordnen sollen, werden die I-Laute offenkundig bevorzugt dem zackigen Gebilde zugerechnet. Wie entstanden die Urwörter? Bestimmte Nervenzellen im Gehirn, Spiegelneuronen, so vermutet er, stellen eine Kongruenz her zwischen

Das sind erlernte Kulturtechniken – chinesische Muttersprachler etwa in den USA können ganz schlecht einem englischen Muttersprachler von den Lippen ablesen, was er sagt. Oliver Sacks hat in „Stumme Stimmen” gezeigt, dass über Gebärdensprache sehr differenziert kommuniziert werden kann und dass sie der akustischen Sprache in nichts nachstehen muss. Wie macht das Gehirn Sprache? Das Gehirn speichert auch nonverbal Wissen ab, getrennt und unabhängig von den Zentren, in denen die Namens-Laute und Begriffe des entsprechenden Gegenstandes, der Handlung oder der emotionalen Erfahrung abrufbar sind. „Von sich aus erzeugt diese nonverbale Information weder die Erfahrung noch das Gefühl des Wissens“, sagt der Neurologe Joel Davis. Lautfolgen werden wie visuelle Eindrücke im Gehirn in winzige Bruchstücke zerlegt und abgespeichert. Eine Neuronengruppe ist für eine Grammatik- Regel zuständig, eine andere für Zeitwörter, wieder eine andere für Worte einer Fremdsprache. Wenn Sprachfunktionen aufgerufen werden, kombiniert das Gehirn durch simultane Aktivität die notwendigen Elemente. „Die Nahtlosigkeit der Sprache ist eine Illusion, die von dem gleichen Organ erzeugt wird, das uns die Wahrnehmung der ‚Realität’ ermöglicht: dem Gehirn.“ (Joel Davis) Zu Bewusstsein gebrachter Sinn von Worten und Sätzen wird erschaffen in Trillionen synaptischer Bahnen und zusammengesetzt aus Laut-Erinnerungsfragmenten. Bei Patienten mit speziellen Hirn-Schädigungen können bestimmte Funktionen der Sprach-Rekombination defekt sein. Es gibt es ein Zentrum, das darauf spezialisiert ist, Worte zu „scannen“ und bekannte Worte wie „Katze“ von unbekannten, nicht identifizierbaren auditiven oder visuellen Eindrücken wie „Kotzur“ zu unterscheiden. Das Gehirn neigt dabei dazu, seinen Sinneseindrücken Sinn zu verleihen: Wir „korrigieren“ Fehler im Schriftbild oder im akustischen Eindruck unbewusst, hören oder sehen das, was wir hören und sehen wollen, wenn die Sinneseindrücke nicht allzu stark von dem Erwarteten (und Gewünschten) abweichen. Die Verteilung der Sprachzentren bei jedem Menschen so einzigartig, dass man einen „Gehirnfingerabdruck“ eines Menschen und speziell einen „Sprachfingerabdruck“ anfertigen könnte. Klar ist nur: Die Zentren der Sprachfunktion liegen in der linken Gehirnhälfte. Das wird mit der Rechtshändigkeit der Mütter in Zusammenhang gebracht, die die Kinder links trugen, um die rechte Hand frei zu haben. Die Rechte entwickelte sich als die „schöne“, geschickte Hand - und die linke Hemisphäre musste sich mächtig entwickeln, um sie zu steuern. Die Zentren für Sprache und für Handfertigkeit liegen beieinander – in der Entwicklungsgeschichte des Homo sapiens war die Fähigkeit, komplexe Muskelgruppen zu steuern, offenbar die „Vorübung“ für die Koordination von Lautgebungs-Muskeln und Laut-Erinnerung. Sprache ist das komplexeste Kommunikationssystem in der Biologie der Lebewesen. Die Frage ist, wie das kindliche Gehirn so etwas lernt. Kinder beherrschen die Sprache, bevor sie Schnürsenkel binden können. Und: Kinder aller Kulturen lernen in denselben Schritten und in denselben „Zeitfenstern“ zu sprechen. Säuglinge lassen sich schon wenige Tage nach der Geburt am liebsten von der Muttersprache und der Sprachmelodie der Mutter beruhigen. Nach etwa einem Jahr kennen und unterscheiden sie die rund 100 Phoneme, die weltweit in Sprachen verwendet werden. Das frühkindliche Gehirn ist universell, auf jede „Muttersprache“ vorbereitet. Allerdings reduziert sich diese Fähigkeit bald auf die Phoneme, die Kleinkinder mit den Bezugspersonen verbinden, denen sie emotional ausgeliefert sind. Laute, die nicht zur Muttersprache gehören, werden ausgeblendet. Asiaten, die in dieser Phase das „r“ als Phonem einer Bezugsperson gelernt haben, können es auch im Erwachsenen-Alter vom „L“ unterscheiden, was Asiaten ansonsten gewöhnlich nicht gelingt. Diese Reduktion erscheint als Spezialisierung, sie geht einher mit der Herausbildung der Fähigkeit, aktiv selbst speziell geformte Sprachlaute zu bilden – eben nur die Laute der „Muttersprache“. Zwischen dem 12. und dem 18. Monat lernen Kinder ihre ersten Worte und bilden ein Erinnerungs-Lexikon von rund 50 Worten heraus, aber nur für ein Vokabular, dessen Bedeutung für ihre emotionalen Bezugspersonen deutlich ist. Aus Video-Filmen lernen Säuglinge und Kleinkinder keine Sprache. Im dritten Lebensjahr entdecken Kinder spielend die Syntax ihrer Sprache: Zweiwortsätze, Dreiwortsätze. Danach schließt sich das sensible Zeitfenster für den Erwerb einer „zweiten Muttersprache“. Kinder spielen mit der Sprache, sie kombinieren Wörter manchmal abenteuerlich, wenn sie dazu ermutigt werden. Kinder erkennen früh grammatikalische Regeln und haben Probleme mit Ausnahmen. Schriftsprache Wie die akustischen Sinneseindrücke müssen auch die visuellen Eindrücke der schriftlich fixierten Buchstaben im Gehirn zu Gesamtbildern kombiniert und dann mit den gespeicherten Schrift- und Laut-Erinnerungsbruchstücken verkettet werden, bevor Schrift als Laut aktiviert und der Sinn der Buchstaben dem Bewusstsein als „verstandene“ Botschaft gemeldet werden kann. Lesen lernen ist daher immer ein lautes oder inneres „Vorlesen“. Leider differenziert die Hirnforschung bisher nur selten zwischen „analphabeten“ Mundarten und den durch Schrift geformten Schriftsprachen. „Das menschliche Gehirn wird durch Lesen geradezu missbraucht”, sagt Ernst Pöppel - weil die neuronalen Verarbeitungsvorgänge so übermäßig komplex sind. Schrift-fixierte Begriffe würden zudem als Realität wahrgenommen - etwa die Seele. Das Leib-Seele-Probleme sei so ein kulturgeschichtliches „Artefakt” der Schriftkultur, sagt Pöppel - durch die Verschriftlichung habe sich das Wort „selbständig gemacht”. Gesellschaften ohne Schrift kennen es nicht: „Wir werden dazu verführt, den schriftlich fixierten Begriffen eigene Identitäten im Gehirn zuzuordnen.” Auffällig ist, dass in alten Kulturen, in denen Sprache ohne eine Fixierung über Schrift die Kommunikation leisten musste, eine deutliche Bindung an Körpersignale bestehen bleibt. Die unterstreichende Handbewegung oder die Miene dient zur Absicherung der Verständigung. Erst in dem Maße, in dem Mundarten zu Schriftsprachen entwickelt wurden, haben wir auditive Repräsentationen, die vollständig unabhängig von einem Körpersignal und einem anderen Wahrnehmungsinput verwendet werden. Was Freud nicht wissen konnte Sigmund Freud hat den Menschen beschrieben als ein von den unbewussten Mächten des Eros und des Todestriebes getriebenes Wesen. Erst das ICH, das sich im Verlaufe der Erziehung entwickelt, kann nach Freud eine Vorstellung davon entwickeln, dass ein ES im Körper wütet, das unter kulturelle Kontrolle zu bringen sei, um Gesellschaft zu ermöglichen. Giacomo Rizolatti, der Entdecker der Spiegelneurone, geht davon aus, dass der Ursprung der Sprache in den Spiegelneuronen zu suchen ist. Primaten verständigen sich mit Gesten und mit Lautbekundungen. Zu solchen Lautbekundungen gehören Mundbewegungen – wie ein Säugling sich an Lauten und Mundbewegung der Mutter orientiert, könnte der Ursprung der Sprache darin gelegen haben, dass Mundbewegungen und Laute zusammen als spezielle „Zeichen“ der Verständigung entwickelt wurden. Erwachsene gönnen ihrem Gehirn dieses frühkindliche Vergnügen des sich „aufeinander Einspiegelns“ als Gefühl des Verliebtseins. Bewegungstherapie, Musiktherapie und Stimmtherapie machen sich die gehirnphysiologisch verankerte Verschränkung von Lauten und Bewegungen zunutze.

siehe auch meine Texte Anmerkungen: 1) Die Schallwellen bringen das Trommelfell zum Vibrieren. Die drei kleinen Gehörknöchelchen des Mittelohrs, Hammer, Amboss und Steigbügel, schwingen mit und verstärken den Schall um das etwa 20-fache. Das eigentliche Hörorgan ist das mit Flüssigkeit gefüllte Innenohr, denn hier liegt die Cochlea (Gehörschnecke), in der viele tausend Sinneszellen mit winzigen Härchen die Vibrationen in einen elektrischen Impuls umwandeln und das Signal an den Hörnerv weiterleiten. So gelangt die Information ins Gehirn, wo es weder Licht noch Ton gibt.

|